Jakie są największe wyzwania etyczne związane ze sztuczną inteligencją?

Czy kiedykolwiek zastanawialiście się, jakie dylematy moralne może przynieść rewolucja technologiczna, jaką jest sztuczna inteligencja? W miarę jak AI staje się coraz bardziej obecna w naszym życiu, pojawiają się pytania, które mogą kształtować przyszłość naszej cywilizacji. To nie tylko kwestia zaawansowanej technologii, ale również tego, jakie wartości chcemy wprowadzać w nasze inteligentne rozwiązania.

Wyobraźcie sobie, że w rękach maszyny leży odpowiedzialność za kluczowe decyzje. Przestrzeń ta, choć pełna możliwości, stawia przed nami poważne wyzwania etyczne. Jak zatem odnaleźć równowagę między postępem a odpowiedzialnością?

Jakie pytania i dylematy będą nam towarzyszyć w tej fascynującej podróży ku przyszłości?

Spis treści

- Jak sztuczna inteligencja wpływa na prywatność?

- Etyka w algorytmach: co warto wiedzieć?

- Sztuczna inteligencja a odpowiedzialność za decyzje

- Jak zapewnić przejrzystość w AI?

- FAQ

- Podsumowanie

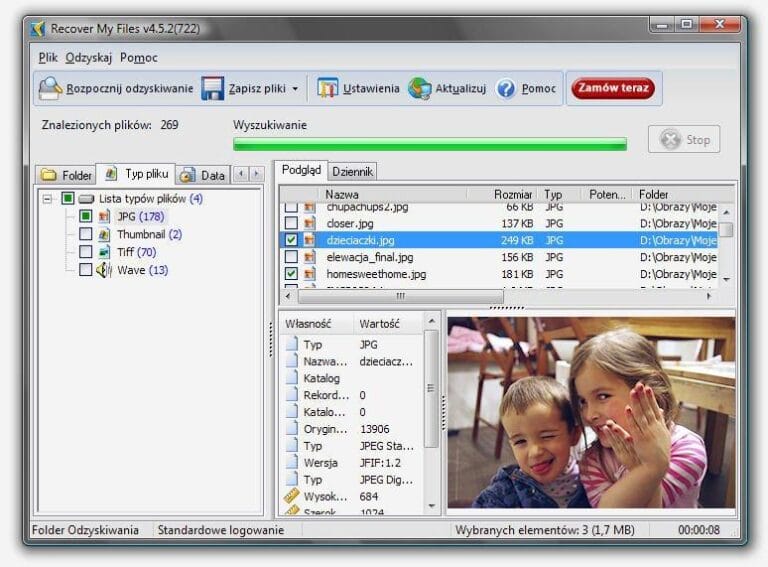

Jak sztuczna inteligencja wpływa na prywatność?

Sztuczna inteligencja (SI) w znaczny sposób wpływa na prywatność jednostki, co staje się coraz bardziej zauważalne w współczesnym społeczeństwie. Wiele aplikacji, które wykorzystują SI, gromadzi dane osobowe, by dostarczać spersonalizowane doświadczenia. Przykładem mogą być asystenci głosowi, którzy słuchają rozmów użytkowników, choć często nie ujawniają, jak dokładnie przetwarzają te informacje. Takie podejście może budzić obawy i wywoływać pytania o granice między wygodą a inwigilacją.

Prawa dotyczące ochrony danych osobowych, takie jak RODO w Unii Europejskiej, stawiają nowe wymagania przed firmami rozwijającymi technologie SI. Firmy muszą teraz transparentnie informować użytkowników o tym,jakie dane zbierają,w jaki sposób je wykorzystują i jak długo je przechowują. Taki krok zwiększa odpowiedzialność czołowych graczy na rynku, a jednocześnie daje użytkownikom większą kontrolę nad własnymi danymi.

Interesującym zjawiskiem jest także wykorzystanie SI w walce z przestępczością.Algorytmy mogą analizować dużą ilość danych, by przewidywać potencjalne zagrożenia, co jest korzystne z perspektywy ochrony społeczeństwa. Jednak pojawia się ryzyko, że takie systemy mogą prowadzić do dyskryminacji lub niewłaściwych oskarżeń, gdyż często bazują na historycznych danych, które same w sobie mogą być stronnicze. Rozważne podejście do etyki w takich przypadkach jest kluczowe dla zachowania równowagi między bezpieczeństwem a prawami jednostki.

Sztuczna inteligencja staje się nieodłącznym elementem życia codziennego. Ważne jest, aby świadomie podchodzić do jej rozwoju i wprowadzenia, pamiętając o wartości, jaką ma nasza prywatność. Edukacja na ten temat oraz tworzenie należytych regulacji mogą wspierać rozwój SI, jednocześnie chroniąc obywateli przed nadużyciami.

Etyka w algorytmach: co warto wiedzieć?

Etyka w algorytmach to temat, który zyskuje na znaczeniu w miarę rozwoju technologii. W algorytmach mogą być zawarte uprzedzenia i stereotypy, które wpływają na decyzje podejmowane przez sztuczną inteligencję. Na przykład, jeśli system uczenia maszynowego jest trenowany na danych, które zawierają nierówności społeczne, to może stworzyć niezrównoważone i niesprawiedliwe wyniki. Ważne jest, aby projektanci algorytmów byli świadomi tych zagrożeń i podejmowali działania mające na celu ich minimalizowanie.

Kolejnym ważnym zagadnieniem jest przejrzystość algorytmów. Wiele osób korzysta z systemów sztucznej inteligencji,nie zdając sobie sprawy,jak działają one „pod maską”.Na przykład, decyzja o tym, czy ktoś otrzyma kredyt, może być podjęta przez algorytm, którego logika jest nieprzejrzysta. Rozwój narzędzi, które umożliwiają użytkownikom zrozumienie, w jaki sposób technologie działają, staje się kluczowy dla zaufania do tych systemów.

Wreszcie, nie można zapominać o odpowiedzialności za działania sztucznej inteligencji. Kto ponosi konsekwencje, gdy algorytm popełni błąd? Na przykład, w przypadku wypadków związanych z autonomicznymi pojazdami, ustalenie winy może być skomplikowane. Warto, aby w przyszłości opracować regulacje i standardy, które jasno określą, kto jest odpowiedzialny za decyzje podejmowane przez sztuczną inteligencję.

Stawiając takie pytania i wprowadzając odpowiednie praktyki, możemy zbudować bardziej etyczną przyszłość, w której technologia będzie wspierać ludzi, a nie ich zastępować. Każdy krok w kierunku większej świadomości etycznej w algorytmach przyczynia się do lepszego wykorzystania sztucznej inteligencji w życiu codziennym.

Sztuczna inteligencja a odpowiedzialność za decyzje

Sztuczna inteligencja staje przed istotnym wyzwaniem związanym z odpowiedzialnością za podejmowane decyzje. W miarę jak AI zyskuje na popularności w różnych dziedzinach, takich jak medycyna czy transport, istotne staje się ustalenie, kto ponosi odpowiedzialność za błędne decyzje podejmowane przez maszyny. Przykładem może być sytuacja, gdy autonomiczny pojazd spowoduje wypadek. Czy odpowiedzialność spoczywa na firmie produkującej system, na programistach, czy może na właścicielu pojazdu? Takie pytania są kluczowe dla dalszego rozwoju technologii.

W artykule z 2021 roku opublikowanym w „Journal of Artificial Intelligence Research”, autorzy podkreślają, że przejrzystość algorytmów jest niezbędna do zrozumienia procesów decyzyjnych AI. Gdy decyzje są trudne do wytłumaczenia, np. w diagnozowaniu chorób przez systemy AI, może to budzić wątpliwości co do zaufania do technologii.Wprowadzenie przepisów dotyczących przejrzystości i audytów algorytmów może pomóc w zwiększeniu odpowiedzialności oraz zapewnieniu, że AI będzie służyć dobru społecznemu.

Inny aspekt dotyczy zagrożeń etycznych związanych z uprzedzeniami w danych, na podstawie których AI podejmuje decyzje. Jeśli systemy uczą się na podstawie historycznych danych, mogą powielać istniejące w społeczeństwie nierówności. Na przykład, użycie algorytmów w policyjnych systemach zdarzeń może prowadzić do dyskryminacji. Właściwe zarządzanie danymi i ich analiza są kluczowe,aby uniknąć powielania takich błędów.

Również ważne jest uwzględnienie etyki w procesie tworzenia AI. Programiści i inżynierowie powinni być świadomi potencjalnych konsekwencji swoich działań. Szkolenie w zakresie etyki oraz różnorodności w zespołach zajmujących się AI może przyczynić się do tworzenia bardziej odpowiedzialnych systemów. Wprowadzenie standardów etycznych w procesie tworzenia technologii niesie ze sobą szansę na rozwój innowacji, które będą bardziej zapewniające równość i sprawiedliwość w społeczeństwie.

Jak zapewnić przejrzystość w AI?

Przejrzystość w sztucznej inteligencji jest kluczowym elementem, który wpływa na zaufanie społeczeństwa do technologii. Firmy powinny wprowadzać jasne zasady działania algorytmów,aby użytkownicy mogli zrozumieć,jak dane są przetwarzane. Na przykład,czytelne rozumienie sposobu,w jaki AI podejmuje decyzje,może pomóc uniknąć nieporozumień oraz obaw związanych z wykorzystaniem danych osobowych.

Oprócz jasnych zasad, warto inwestować w szkolenia i edukację zarówno pracowników, jak i użytkowników. Organizacje mogą organizować warsztaty oraz webinaria, które pomogą w zrozumieniu działania technologii AI. Przykładem mogą być programy w szkołach, które uczą młodzież, jak działa sztuczna inteligencja i jakie ma konsekwencje w rzeczywistości. Tego rodzaju działania pozwalają rozwijać zdrowe podejście do nowych technologii i ograniczać strach przed nimi.

Transparentność algorytmów może również zaowocować większą odpowiedzialnością firm.Gdy użytkownicy wiedzą, na jakiej podstawie AI podejmuje decyzje, mogą skuteczniej zgłaszać wszelkie nieprawidłowości. Na przykład, w sytuacjach, gdy AI generuje niepożądane wyniki, pracownicy mogą szybko reagować i wprowadzać zmiany, co zwiększa bezpieczeństwo korzystania z technologii.

Zarządzanie przejrzystością wymaga także współpracy z innymi podmiotami.Firmy powinny brać pod uwagę opinie oraz rady zewnętrznych ekspertów i organizacji pozarządowych, które zajmują się etyką w technologii.Takie działania uplasują odpowiedzialność na pierwszym miejscu, a także budują wizerunek organizacji jako społecznie odpowiedzialnych.

FAQ

Jakie są główne obawy związane z etyką sztucznej inteligencji?

Główne obawy dotyczące etyki sztucznej inteligencji obejmują prywatność danych, błędy w algorytmach oraz stronniczość decyzji podejmowanych przez maszyny. W miarę jak sztuczna inteligencja staje się coraz bardziej zaawansowana, istotne jest, aby zapewnić, że jej rozwój i zastosowanie będą zgodne z zasadami etycznymi.

Jak można zapobiegać stronniczości w algorytmach AI?

Aby zapobiegać stronniczości, kluczowe jest rozsądne zbieranie danych oraz przeprowadzanie testów audytowych w celu identyfikacji potencjalnych nieprawidłowości. Pracując nad algorytmami, warto angażować zespoły z różnych środowisk, co pozwala na wzbogacenie perspektyw i zwiększa sprawiedliwość decyzji podejmowanych przez sztuczną inteligencję.

Jakie są korzyści płynące z etycznego podejścia do AI?

Etyczne podejście do sztucznej inteligencji przynosi szereg korzyści, takich jak zwiększone zaufanie społeczeństwa, wzrost innowacyjności oraz profity ekonomiczne. Firmy, które kładą nacisk na odpowiedzialne wykorzystanie AI, mogą cieszyć się lepszą reputacją oraz długoterminowymi zyskami.

Jakie wyzwania stawia wprowadzenie regulacji prawnych w obszarze AI?

Wprowadzenie regulacji prawnych może napotkać różne wyzwania, takie jak trudność w utrzymaniu tempa rozwoju technologii oraz potrzeba jasnych definicji odpowiedzialności. Ważne jest, aby przepisy były elastyczne i dostosowywały się do szybko zmieniającego się krajobrazu sztucznej inteligencji, aby nie hamowały innowacji, a jednocześnie chroniły prawa obywateli.

Jak możemy edukować społeczeństwo na temat etyki AI?

Edukacja społeczeństwa w zakresie etyki sztucznej inteligencji może odbywać się poprzez warsztaty, szkolenia oraz kampanie informacyjne. Kluczowe jest, aby wszystkie grupy społeczne miały dostęp do informacji oraz mogły angażować się w dyskusje dotyczące przyszłości AI, co wpłynie na pozytywny rozwój technologii w zgodzie z wartościami etycznymi.

Podsumowanie

Sztuczna inteligencja przypomina nowoczesnego Syzyfa, który wciąż toczy kamień etycznych dylematów pod górę. Największym wyzwaniem staje się balansowanie między innowacją a odpowiedzialnością, gdyż każda decyzja dotycząca AI ma potencjał, by kształtować przyszłość społeczeństwa. Jakie zasady chcemy wbudować w ten cyfrowy świat, by nie stał się on labiryntem moralnych wyborów? To od nas zależy, czy AI stanie się naszym sprzymierzeńcem, czy przeciwnikiem.